收費課程 - Kubernetes 容器編排平台導入

讓機器管機器,你才能專注在最有價值的工作上

課程推廣

為應付更龐大的流量,許多企業開始將傳統架構轉型成微服務架構,而微服務架構往往牽涉到部署與管理大規模伺服器叢集, 而 Kubernetes 不僅使用到容器技術,更結合 Google 自身多年經驗,將微服務管理變得更為輕鬆。

近年來許多 DevOps、SRE 職缺開始將 Kubernetes 列為面試加分選項,相信未來技術越加普及後會逐漸成為職缺必要條件。用一堂實體課程時間,學習新技能讓自己職業生涯越走越順!

但對於剛接觸的人來說,常會被不同用途的 Controller、Volume、Service 概念搞得頭昏眼花。因此於 2020/10/17、10/24 我會開設 2020 北部實體線下課程 「Kubernetes 容器編排平台導入」, 讓更多人能真正瞭解 Kubernetes 的精髓,並能真正應用於他們日常工作上。

課程內容

內容會從 Kubernetes 基礎開始教起,接著學習進階內容最後上機練習。

你會學到在這個部落格內的 Kubernetes 內容的精華版,並且我會分享使用於生產環境的經驗,以及該如何避免採坑。

基礎概念

- Container (Docker)

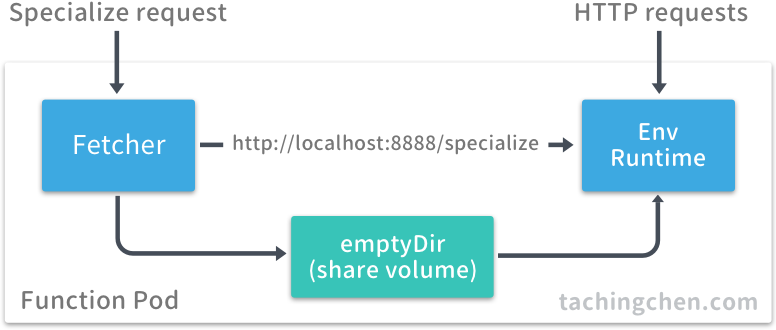

- Kubernetes 核心架構介紹

- Kubernetes Pod

- Kubernetes Service

- Kubernetes Volume

- K8S Configuration

- 實戰訓練

- 指令使用與聲明式宣告

- 物件組合與應用

- 系統操作、除錯、分析